Tipo: Hacker News Discussion

Link originale: https://news.ycombinator.com/item?id=45596059

Data pubblicazione: 2025-10-15

Autore: talhof8

Sintesi #

WHAT - Recursive Language Models (RLMs) sono un’inferenza strategica che permette ai modelli linguistici di decomporre e interagire ricorsivamente con contesti di input di lunghezza illimitata attraverso ambienti REPL.

WHY - RLMs risolvono il problema della “context rot” e permettono di gestire input e output di lunghezza illimitata, migliorando l’efficienza e la precisione dei modelli linguistici.

WHO - Gli attori principali sono i ricercatori e sviluppatori di modelli linguistici, con un focus su GPT e GPT-mini.

WHERE - RLMs si posizionano nel mercato delle tecnologie AI per il trattamento di contesti lunghi e complessi, integrandosi con modelli linguistici esistenti.

WHEN - RLMs sono una tecnologia emergente, con risultati promettenti che indicano un potenziale futuro significativo.

BUSINESS IMPACT:

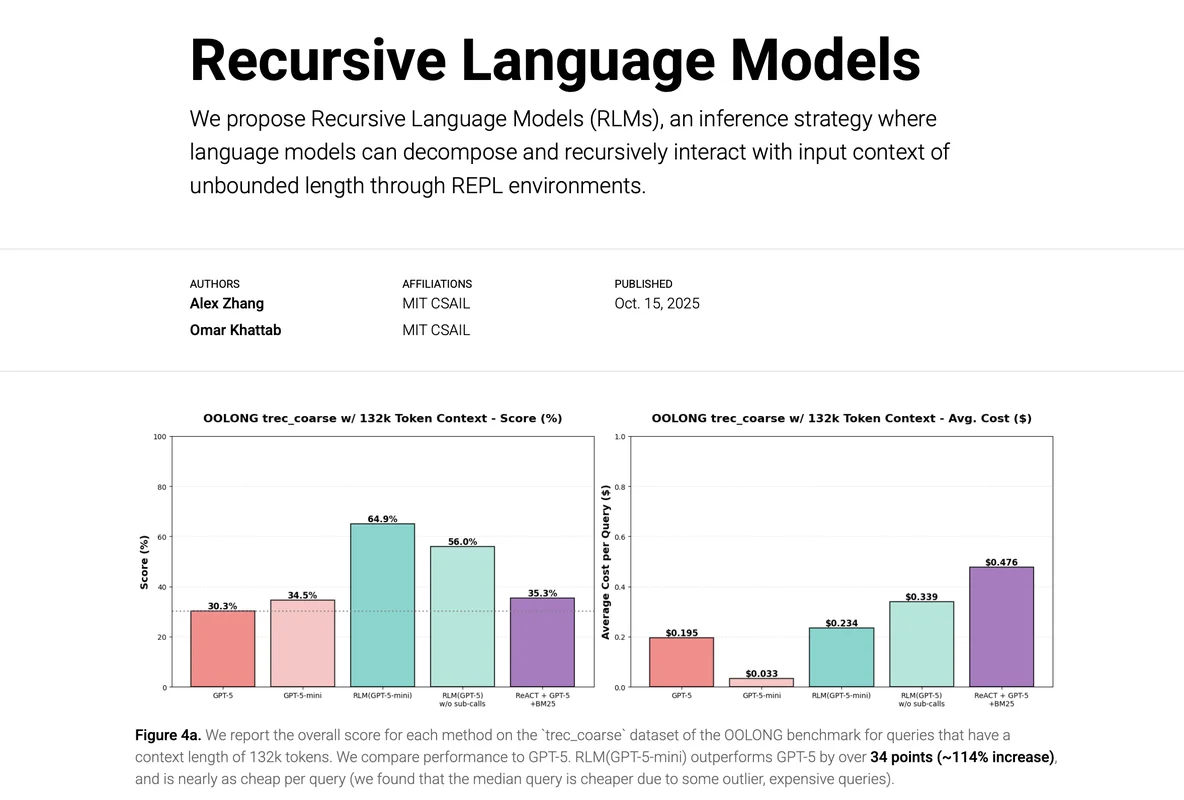

- Opportunità: RLMs offrono un vantaggio competitivo nel trattamento di contesti lunghi, migliorando la precisione e riducendo i costi per query. Ad esempio, un RLM basato su GPT-mini ha superato GPT in benchmark difficili, riducendo i costi per query. RLMs possono essere integrati in sistemi di ricerca avanzata e analisi di dati complessi.

- Rischi: La competizione con altri modelli avanzati come ReAct e CoT-style reasoning potrebbe rappresentare una minaccia. Tuttavia, RLMs mostrano una resilienza superiore in contesti lunghi.

- Integrazione: RLMs possono essere integrati con lo stack esistente di modelli linguistici, migliorando le capacità di elaborazione di contesti lunghi e complessi.

TECHNICAL SUMMARY:

- Core technology stack: RLMs utilizzano modelli linguistici come GPT e GPT-mini, integrati in ambienti REPL Python. La strategia di inferenza ricorsiva permette di gestire contesti di lunghezza illimitata.

- Scalabilità: RLMs dimostrano una scalabilità superiore, mantenendo la performance anche con input di milioni di token.

- Differenziatori tecnici: La capacità di gestire contesti lunghi senza degradazione della performance e l’efficienza dei costi per query.

DISCUSSIONE HACKER NEWS: La discussione su Hacker News ha evidenziato principalmente l’interesse per RLMs come strumento innovativo per risolvere problemi di contesto lungo. I temi principali emersi sono stati l’utilità pratica di RLMs, i problemi risolti e le potenziali applicazioni API. Il sentimento generale della community è positivo, con un riconoscimento delle potenzialità di RLMs nel migliorare le capacità dei modelli linguistici esistenti.

Casi d’uso #

- Private AI Stack: Integrazione in pipeline proprietarie

- Client Solutions: Implementazione per progetti clienti

Feedback da terzi #

Community feedback: La community HackerNews ha commentato con focus su tool, problem (18 commenti).

Risorse #

Link Originali #

- Recursive Language Models (RLMs) - Link originale

Articolo segnalato e selezionato dal team Human Technology eXcellence elaborato tramite intelligenza artificiale (in questo caso con LLM HTX-EU-Mistral3.1Small) il 2026-01-15 08:03 Fonte originale: https://news.ycombinator.com/item?id=45596059

Articoli Correlati #

- Show HN: AutoThink – Boosts local LLM performance with adaptive reasoning - LLM, Foundation Model

- My trick for getting consistent classification from LLMs - Foundation Model, Go, LLM

- GitHub - fullstackwebdev/rlm_repl: Recursive Language Models (RLMs) implementation based on the paper by Zhang, Kraska, and Khattab - Open Source, Python, Foundation Model