Tipo: Web Article

Link originale: https://alexzhang13.github.io/blog/2025/rlm/

Data pubblicazione: 2026-01-15

Autore: Alex L. Zhang

Sintesi #

Introduzione #

Immagina di dover gestire conversazioni lunghe e complesse con un modello linguistico. Dopo un po’, il modello inizia a perdere il filo del discorso, dimenticando dettagli importanti e rendendo le risposte meno accurate. Questo fenomeno, noto come “context rot”, è un problema comune nei modelli linguistici attuali. Ora, immagina di avere uno strumento che può decomporre e interagire ricorsivamente con il contesto di input di lunghezza illimitata, mantenendo sempre alta la qualità delle risposte. Questo è esattamente ciò che propongono i Recursive Language Models (RLMs), un’inferenza strategica che promette di rivoluzionare il modo in cui interagiamo con i modelli linguistici.

I RLMs sono particolarmente rilevanti oggi, in un’epoca in cui la quantità di dati e la complessità delle interazioni stanno crescendo esponenzialmente. La capacità di gestire contesti lunghi e complessi senza perdere informazioni è cruciale per applicazioni come l’assistenza virtuale, la ricerca accademica e la generazione di contenuti. In questo articolo, esploreremo cosa sono i RLMs, come funzionano e perché rappresentano un passo avanti significativo nel campo dell’intelligenza artificiale.

Di Cosa Parla #

I Recursive Language Models (RLMs) sono un’inferenza strategica che permette ai modelli linguistici di decomporre e interagire ricorsivamente con il contesto di input di lunghezza illimitata attraverso ambienti REPL (Read-Eval-Print Loop). In pratica, un RLM può chiamare se stesso o altri modelli linguistici per elaborare input complessi, mantenendo alta la qualità delle risposte. Questo approccio è simile a quello di un programma che si chiama ricorsivamente per risolvere problemi complessi, ma applicato ai modelli linguistici.

Pensa ai RLMs come a un modello linguistico che può suddividere un problema grande in sottoproblemi più piccoli, risolvere ciascuno di essi e poi combinare i risultati per ottenere una risposta finale. Questo è possibile grazie a un ambiente REPL, che permette al modello di interagire con il contesto di input come se fosse un programma. Ad esempio, un RLM può leggere e scrivere in un notebook Python, utilizzando il contesto di input come variabile in memoria. Questo approccio non solo migliora la capacità del modello di gestire contesti lunghi, ma riduce anche il costo delle query, rendendo i RLMs una soluzione efficiente e potente.

Perché È Rilevante #

I RLMs rappresentano un passo avanti significativo nel campo dell’intelligenza artificiale per diverse ragioni. Innanzitutto, mitigano il problema del “context rot”, migliorando la capacità dei modelli linguistici di gestire contesti lunghi e complessi. Questo è particolarmente utile in scenari come l’assistenza virtuale, dove le conversazioni possono diventare lunghe e intricate. Ad esempio, un RLM può gestire una conversazione di migliaia di token senza perdere il filo del discorso, migliorando significativamente l’esperienza utente.

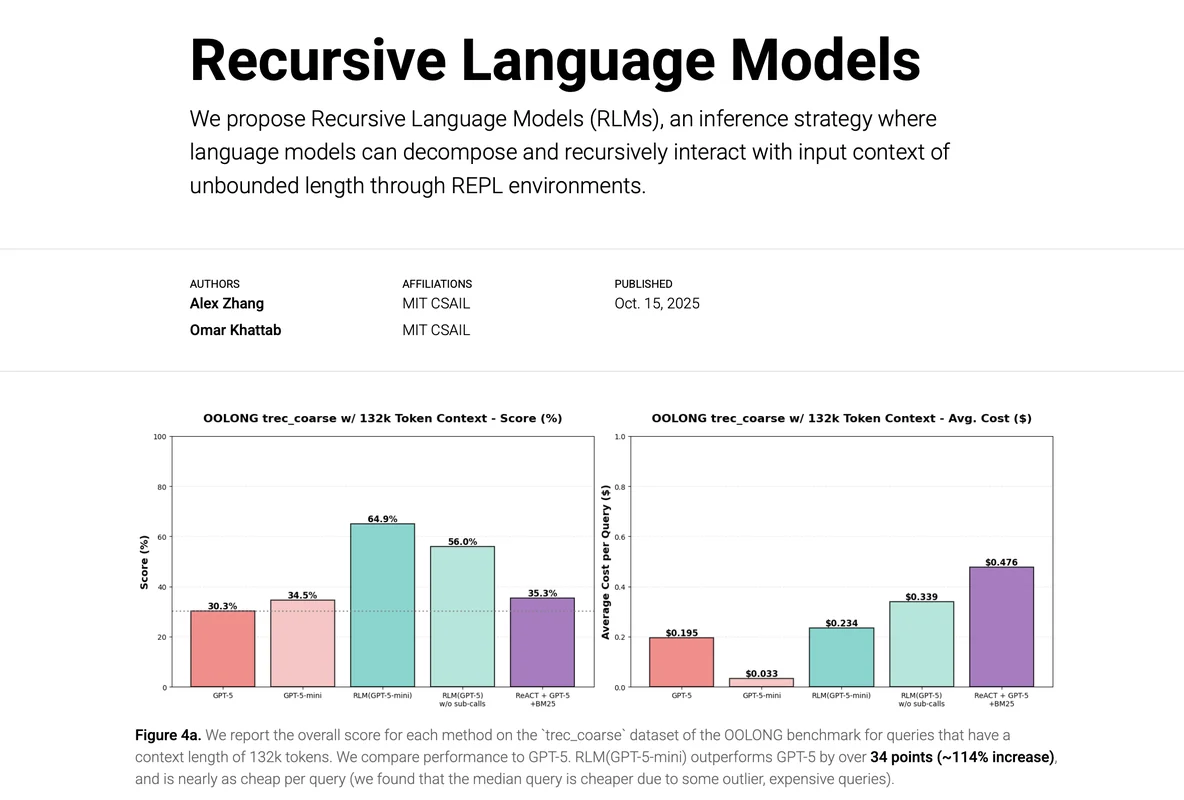

Inoltre, i RLMs sono più efficienti dal punto di vista dei costi. In uno studio condotto da Alex L. Zhang, un RLM che utilizza GPT-mini ha superato GPT in un benchmark di contesti lunghi, raddoppiando il numero di risposte corrette e riducendo il costo delle query. Questo rende i RLMs una soluzione attraente per aziende e sviluppatori che cercano di ottimizzare le risorse senza compromettere la qualità delle risposte.

Infine, i RLMs aprono nuove possibilità per l’inferenza a tempo di esecuzione. Secondo Zhang, i RLMs rappresentano il prossimo milione di inferenza a tempo di esecuzione dopo i modelli di ragionamento CoT-style e ReAct-style. Questo significa che i RLMs potrebbero diventare uno standard per l’inferenza a tempo di esecuzione, migliorando la capacità dei modelli linguistici di gestire contesti complessi e lunghi.

Applicazioni Pratiche #

I RLMs hanno un ampio spettro di applicazioni pratiche. Ad esempio, possono essere utilizzati in sistemi di assistenza virtuale per gestire conversazioni lunghe e complesse senza perdere il filo del discorso. Questo è particolarmente utile in settori come il supporto clienti, dove le conversazioni possono diventare intricate e richiedere un alto livello di precisione.

Un altro scenario d’uso è la ricerca accademica. I RLMs possono essere utilizzati per analizzare grandi quantità di testo, come articoli scientifici o libri, senza perdere informazioni importanti. Questo può migliorare la capacità dei ricercatori di trovare informazioni rilevanti e di generare nuove ipotesi.

Per gli sviluppatori, i RLMs offrono un ambiente REPL che può essere utilizzato per testare e migliorare i modelli linguistici. Ad esempio, un RLM può essere utilizzato per testare la capacità di un modello di gestire contesti lunghi e complessi, identificando eventuali problemi e migliorando la qualità delle risposte.

Per approfondire, puoi consultare il paper completo e il codice ufficiale dei Recursive Language Models (RLMs) disponibili sui link forniti nell’articolo originale.

Considerazioni Finali #

I Recursive Language Models (RLMs) rappresentano un passo avanti significativo nel campo dell’intelligenza artificiale, offrendo una soluzione efficace per gestire contesti lunghi e complessi. La capacità di decomporre e interagire ricorsivamente con il contesto di input attraverso ambienti REPL apre nuove possibilità per l’inferenza a tempo di esecuzione, migliorando la qualità delle risposte e riducendo i costi.

In un’epoca in cui la quantità di dati e la complessità delle interazioni stanno crescendo esponenzialmente, i RLMs offrono una soluzione potente e versatile. Che tu sia un ricercatore, un sviluppatore o un utente finale, i RLMs possono migliorare la tua capacità di gestire contesti complessi e lunghi, rendendo le tue interazioni con i modelli linguistici più efficaci e accurate.

Casi d’uso #

- Private AI Stack: Integrazione in pipeline proprietarie

- Client Solutions: Implementazione per progetti clienti

Risorse #

Link Originali #

- Recursive Language Models | Alex L. Zhang - Link originale

Articolo segnalato e selezionato dal team Human Technology eXcellence elaborato tramite intelligenza artificiale (in questo caso con LLM HTX-EU-Mistral3.1Small) il 2026-01-15 08:04 Fonte originale: https://alexzhang13.github.io/blog/2025/rlm/

Articoli Correlati #

- Recursive Language Models (RLMs) - AI, Foundation Model, LLM

- Recursive Language Models: the paradigm of 2026 - Natural Language Processing, Foundation Model, LLM

- Reimagining LLM Memory: Using Context as Training Data Unlocks Models That Learn at Test-Time - Natural Language Processing, AI, Foundation Model