Tipo: GitHub Repository

Link originale: https://github.com/unclecode/crawl4ai

Data pubblicazione: 2026-01-15

Sintesi #

Introduzione #

Immagina di essere un ricercatore che sta lavorando a un progetto di intelligenza artificiale. Hai bisogno di raccogliere dati da centinaia di siti web per addestrare il tuo modello di linguaggio. Ogni sito ha una struttura diversa, e alcuni richiedono autenticazione o hanno protezioni anti-bot. Tradizionalmente, questo compito richiederebbe settimane di lavoro manuale e l’uso di strumenti costosi e complicati. Ora, immagina di poter automatizzare tutto questo processo con un semplice script Python. Questo è esattamente ciò che ti permette di fare Crawl4AI, un web crawler e scraper open-source progettato per essere amico dei modelli di linguaggio (LLM).

Crawl4AI è stato creato per risolvere i problemi comuni che i ricercatori e gli sviluppatori affrontano quando devono raccogliere dati web. Grazie alla sua architettura modulare e alla sua capacità di generare output in Markdown pronto per i modelli di linguaggio, Crawl4AI rende il processo di estrazione dati veloce, affidabile e accessibile. Non è solo uno strumento per gli esperti di web scraping, ma un alleato per chiunque abbia bisogno di dati web puliti e strutturati.

Cosa Fa #

Crawl4AI è un web crawler e scraper open-source che trasforma il contenuto web in Markdown pronto per i modelli di linguaggio (LLM). Pensalo come un assistente virtuale che naviga il web per te, raccogliendo informazioni e organizzandole in un formato leggibile e utilizzabile. Il progetto è scritto in Python, un linguaggio ampiamente utilizzato e apprezzato per la sua semplicità e potenza.

Le funzionalità principali di Crawl4AI includono la capacità di estrarre dati da siti web di qualsiasi tipo, gestire autenticazioni complesse e bypassare protezioni anti-bot. Inoltre, Crawl4AI è progettato per essere estremamente veloce e scalabile, grazie all’uso di pool di browser asincroni e caching intelligente. Questo significa che puoi eseguire crawling su larga scala senza preoccuparti di rallentamenti o blocchi.

Perché È Straordinario #

Il fattore “wow” di Crawl4AI risiede nella sua capacità di trasformare il web scraping in un processo semplice e accessibile. Non è un semplice crawler lineare che si limita a scaricare pagine web; è uno strumento dinamico e contestuale che comprende e adatta il suo comportamento in base al contesto.

Dinamico e contestuale: #

Crawl4AI non si limita a scaricare pagine web; analizza il contenuto e lo struttura in Markdown, rendendolo immediatamente utilizzabile per i modelli di linguaggio. Ad esempio, se stai estraendo dati da un sito di notizie, Crawl4AI può riconoscere titoli, paragrafi e citazioni, e organizzarli in un formato leggibile. Questo è particolarmente utile per chi lavora con Retrieval-Augmented Generation (RAG) o agenti conversazionali, poiché fornisce un input strutturato e coerente.

Ragionamento in tempo reale: #

Uno degli aspetti più straordinari di Crawl4AI è la sua capacità di ragionare in tempo reale. Grazie all’uso di tecniche avanzate di machine learning, Crawl4AI può adattare il suo comportamento in base alle risposte del sito web. Ad esempio, se un sito richiede autenticazione, Crawl4AI può riconoscere il modulo di login e inserire automaticamente le credenziali fornite. Questo rende il processo di scraping estremamente robusto e affidabile, anche in presenza di protezioni anti-bot complesse.

Esempi concreti: #

Immagina di dover estrarre dati da un sito di e-commerce per analizzare le recensioni dei clienti. Con Crawl4AI, puoi scrivere un semplice script Python che naviga il sito, raccoglie le recensioni e le struttura in un formato leggibile. Ecco un esempio di come potrebbe apparire il codice:

import asyncio

from crawl4ai import *

async def main():

async with AsyncWebCrawler() as crawler:

result = await crawler.arun(

url="https://www.example.com/reviews",

)

print(result.markdown)

if __name__ == "__main__":

asyncio.run(main())

In questo esempio, Crawl4AI estrae le recensioni dal sito e le converte in Markdown, rendendole immediatamente utilizzabili per l’analisi. Questo è solo uno dei molti scenari in cui Crawl4AI può fare la differenza.

Come Provarlo #

Provare Crawl4AI è semplice e diretto. Ecco come puoi iniziare:

-

Clona il repository: Puoi trovare il codice sorgente su GitHub all’indirizzo https://github.com/unclecode/crawl4ai. Clona il repository sul tuo computer usando il comando

git clone https://github.com/unclecode/crawl4ai.git. -

Prerequisiti: Assicurati di avere Python 3.8 o superiore installato sul tuo sistema. Inoltre, ti serviranno alcune dipendenze che puoi installare usando pip. Ecco un esempio di come installare le dipendenze:

pip install -r requirements.txt

-

Configurazione: Crawl4AI è altamente configurabile. Puoi trovare la documentazione principale e le istruzioni di configurazione nel file README e nella sezione Self-Hosting Guide del sito ufficiale.

-

Esegui il crawler: Una volta configurato, puoi eseguire il crawler con un semplice script Python. Ecco un esempio di come avviare un crawler asincrono:

import asyncio

from crawl4ai import *

async def main():

async with AsyncWebCrawler() as crawler:

result = await crawler.arun(

url="https://www.example.com",

)

print(result.markdown)

if __name__ == "__main__":

asyncio.run(main())

Non esiste una demo one-click, ma la configurazione è abbastanza semplice e ben documentata. Se hai bisogno di supporto, puoi unirti alla community su Discord all’indirizzo https://discord.gg/jP8KfhDhyN.

Considerazioni Finali #

Crawl4AI rappresenta un passo avanti significativo nel mondo del web scraping e dell’estrazione dati. La sua capacità di trasformare il contenuto web in Markdown pronto per i modelli di linguaggio lo rende uno strumento indispensabile per ricercatori, sviluppatori e chiunque abbia bisogno di dati web puliti e strutturati.

Nel contesto più ampio dell’ecosistema tech, Crawl4AI si posiziona come un alleato potente per chi lavora con intelligenza artificiale e machine learning. La sua architettura modulare e la sua capacità di adattarsi a diverse situazioni lo rendono uno strumento versatile e affidabile.

In conclusione, Crawl4AI non è solo uno strumento per il web scraping; è una porta verso nuove possibilità di analisi e innovazione. Se sei pronto a portare il tuo progetto al livello successivo, dai un’occhiata a Crawl4AI e scopri come può trasformare il modo in cui raccogli e utilizzi i dati web.

Casi d’uso #

- Private AI Stack: Integrazione in pipeline proprietarie

- Client Solutions: Implementazione per progetti clienti

- Development Acceleration: Riduzione time-to-market progetti

Risorse #

Link Originali #

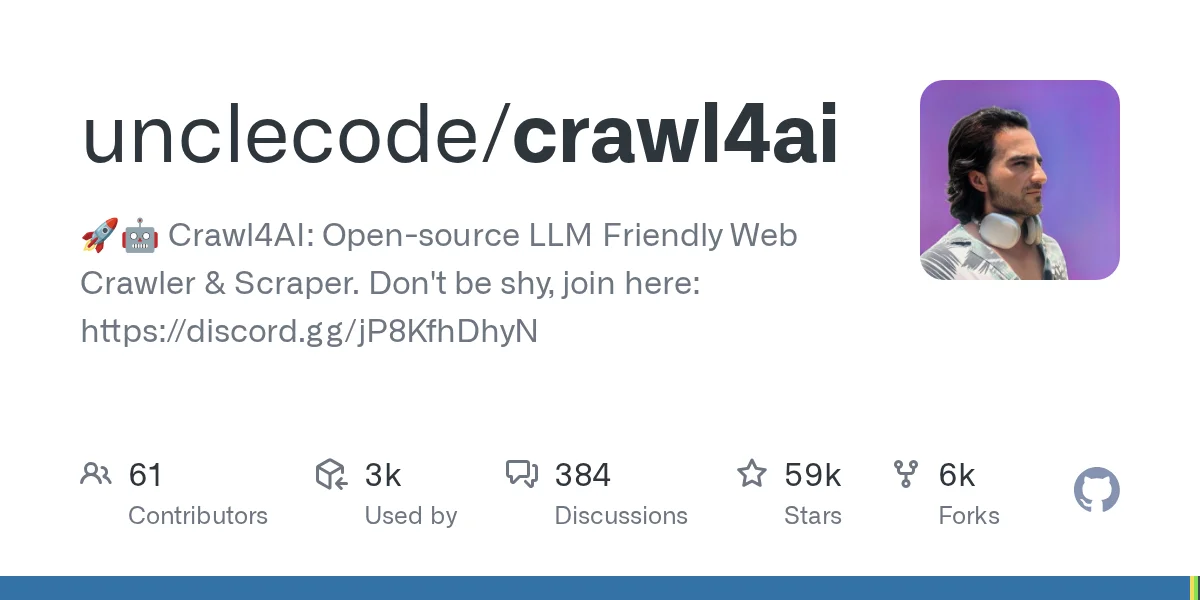

- GitHub - unclecode/crawl4ai: 🚀🤖 Crawl4AI: Open-source LLM Friendly Web Crawler & Scraper. Don’t be shy, join here: https://discord.gg/jP8KfhDhyN - Link originale

Articolo segnalato e selezionato dal team Human Technology eXcellence elaborato tramite intelligenza artificiale (in questo caso con LLM HTX-EU-Mistral3.1Small) il 2026-01-15 08:07 Fonte originale: https://github.com/unclecode/crawl4ai

Articoli Correlati #

- GitHub - google/langextract: A Python library for extracting structured information from unstructured text using LLMs with precis - Go, Open Source, Python

- GitHub - DGoettlich/history-llms: Information hub for our project training the largest possible historical LLMs. - AI, Go, Open Source

- GitHub - different-ai/openwork: An open-source alternative to Claude Cowork, powered by OpenCode - AI, Typescript, Open Source