Tipo: Web Article

Link originale: https://www.krupadave.com/articles/everything-about-transformers?x=v3

Data pubblicazione: 2024-01-15

Sintesi #

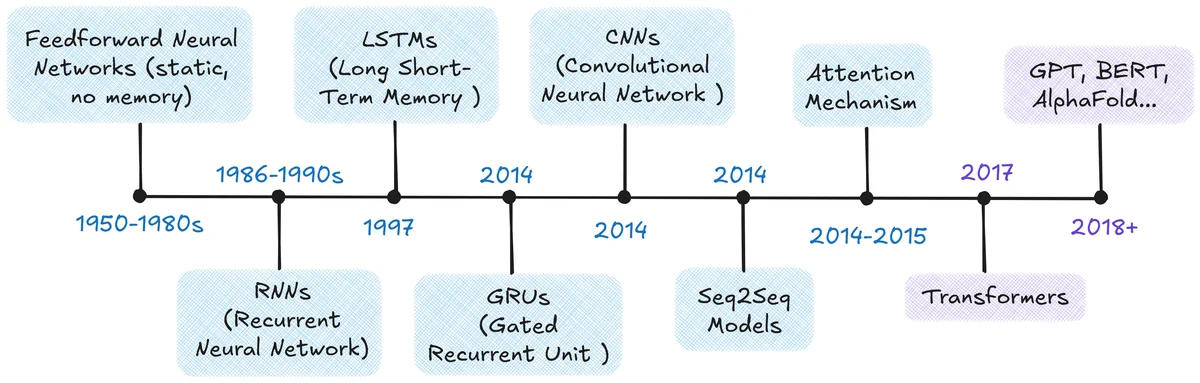

WHAT - Questo articolo parla della storia e del funzionamento dell’architettura dei transformer, un modello di deep learning fondamentale per il trattamento del linguaggio naturale (NLP). Fornisce una spiegazione visiva e intuitiva dell’evoluzione dei modelli di linguaggio, dall’uso delle reti neurali ricorrenti (RNN) fino ai moderni transformer.

WHY - È rilevante per il business AI perché i transformer sono alla base di molti modelli di NLP avanzati, come BERT e GPT. Comprendere il loro funzionamento e la loro evoluzione è cruciale per sviluppare nuove soluzioni AI competitive.

WHO - L’autore è Krupa Dave, un esperto nel campo dell’AI. L’articolo è pubblicato sul sito personale di Dave, che si rivolge a un pubblico tecnico interessato all’AI e al machine learning.

WHERE - Si posiziona nel mercato dell’educazione tecnica e della divulgazione scientifica nel campo dell’AI. È utile per professionisti e ricercatori che vogliono approfondire la comprensione dei transformer.

WHEN - L’articolo è stato pubblicato il 15 gennaio 2024, riflettendo le conoscenze attuali e le tendenze recenti nel campo dell’AI.

BUSINESS IMPACT:

- Opportunità: Fornisce una base solida per lo sviluppo di nuovi modelli di NLP, migliorando la competenza interna sull’architettura dei transformer.

- Rischi: Non rappresenta un rischio diretto, ma ignorare le innovazioni descritte potrebbe portare a un ritardo competitivo.

- Integrazione: Può essere utilizzato per formare il team tecnico, migliorando la capacità di innovazione e sviluppo di nuovi prodotti AI.

TECHNICAL SUMMARY:

- Core technology stack: L’articolo discute l’architettura dei transformer, inclusi encoder, decoder, meccanismi di attenzione (self-attention, cross-attention, masked self-attention, multi-head attention), reti feed-forward, normalizzazione dei layer, codifica posizionale e connessioni residuali.

- Scalabilità e limiti architetturali: I transformer sono noti per la loro capacità di scalare efficacemente, permettendo il trattamento di sequenze di dati in parallelo. Tuttavia, richiedono risorse computazionali significative.

- Differenziatori tecnici chiave: L’uso dell’attenzione come meccanismo principale per il trattamento delle sequenze di dati, permettendo una maggiore flessibilità e precisione rispetto ai modelli precedenti.

Casi d’uso #

- Private AI Stack: Integrazione in pipeline proprietarie

- Client Solutions: Implementazione per progetti clienti

- Strategic Intelligence: Input per roadmap tecnologica

- Competitive Analysis: Monitoring ecosystem AI

Risorse #

Link Originali #

- Everything About Transformers - Link originale

Articolo segnalato e selezionato dal team Human Technology eXcellence elaborato tramite intelligenza artificiale (in questo caso con LLM HTX-EU-Mistral3.1Small) il 2025-10-31 07:33 Fonte originale: https://www.krupadave.com/articles/everything-about-transformers?x=v3

Articoli Correlati #

- Requests for Startups | Y Combinator - Tech

- Stanford’s ALL FREE Courses [2024 & 2025] ❯ CS230 - Deep Learni… - LLM, Transformer, Deep Learning

- AI Act, c’è il codice di condotta per un approccio responsabile e facilitato per le Pmi - Cyber Security 360 - Best Practices, AI, Go