Tipo: Hacker News Discussion

Link originale: https://news.ycombinator.com/item?id=44110584

Data pubblicazione: 2025-05-27

Autore: simonw

Sintesi #

WHAT #

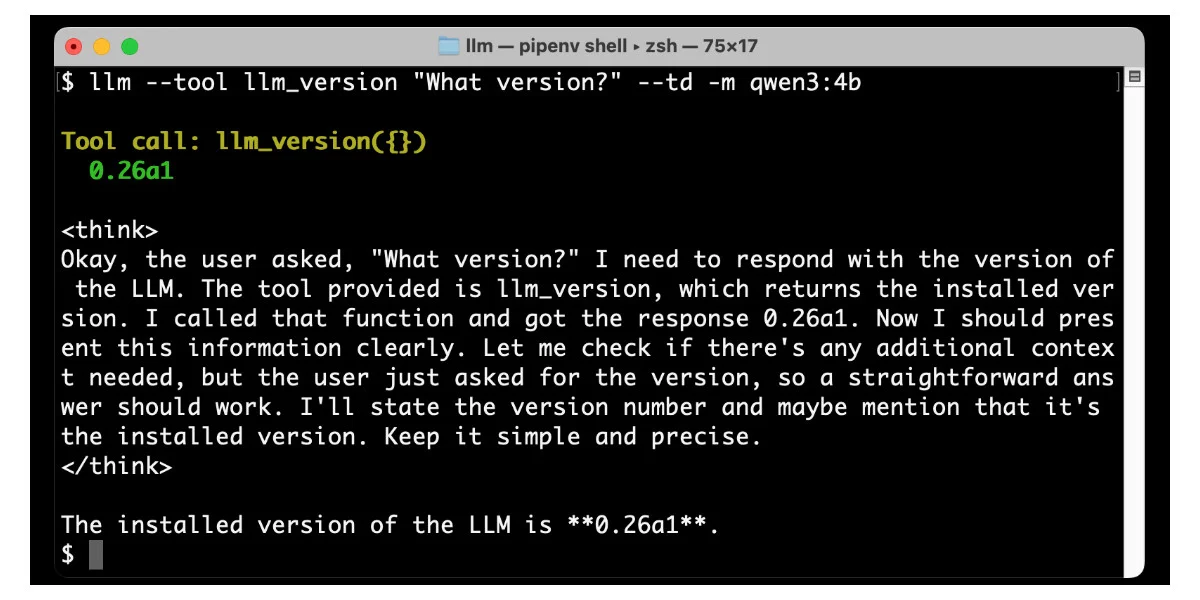

LLM è un tool che permette di integrare modelli linguistici (LLM) con strumenti rappresentati come funzioni Python. Supporta modelli di OpenAI, Anthropic, Gemini e modelli locali di Ollama, offrendo plugin per estendere le capacità dei modelli.

WHY #

È rilevante per il business AI perché permette di estendere le funzionalità dei modelli linguistici con strumenti specifici, migliorando l’efficacia e l’utilità delle applicazioni AI. Risolve il problema di integrare strumenti esterni in modo semplice e scalabile.

WHO #

Gli attori principali includono l’azienda che sviluppa LLM, le community di sviluppatori che utilizzano Python, e i competitor come OpenAI, Anthropic, e Google con i loro modelli linguistici.

WHERE #

LLM si posiziona nel mercato degli strumenti per lo sviluppo di applicazioni AI, offrendo un framework che facilita l’integrazione di modelli linguistici con strumenti esterni. È parte dell’ecosistema AI che include modelli linguistici avanzati e strumenti di sviluppo.

WHEN #

LLM è un progetto relativamente nuovo, ma già maturo per l’uso pratico. Il rilascio della nuova feature di supporto per strumenti rappresenta un passo significativo nella sua evoluzione, indicando un trend di crescita e adozione.

BUSINESS IMPACT #

- Opportunità: Integrazione rapida di strumenti specifici nelle applicazioni AI, migliorando la funzionalità e l’efficacia dei modelli linguistici.

- Rischi: Competizione con altri framework di integrazione e la necessità di mantenere aggiornati i plugin per i modelli linguistici.

- Integrazione: Possibile integrazione con lo stack esistente attraverso l’uso di plugin e funzioni Python, facilitando l’adozione e l’espansione delle capacità AI.

TECHNICAL SUMMARY #

- Core technology stack: Python, modelli linguistici di OpenAI, Anthropic, Gemini, e Ollama.

- Scalabilità: Alta scalabilità grazie all’uso di funzioni Python e plugin, permettendo l’integrazione di nuovi strumenti senza modifiche significative al core del sistema.

- Differenziatori tecnici: Supporto per plugin e integrazione semplice con modelli linguistici, offrendo una flessibilità unica nel mercato.

DISCUSSIONE HACKER NEWS #

La discussione su Hacker News ha evidenziato principalmente l’interesse per le nuove funzionalità di integrazione degli strumenti e il framework di supporto. I temi principali emersi sono stati la facilità d’uso del tool, la performance dei modelli integrati, e la flessibilità del framework. La community ha espresso un sentimento positivo riguardo alle potenzialità del tool, apprezzando la possibilità di estendere le capacità dei modelli linguistici con strumenti specifici.

Casi d’uso #

- Private AI Stack: Integrazione in pipeline proprietarie

- Client Solutions: Implementazione per progetti clienti

- Development Acceleration: Riduzione time-to-market progetti

- Strategic Intelligence: Input per roadmap tecnologica

- Competitive Analysis: Monitoring ecosystem AI

Feedback da terzi #

Community feedback: La community HackerNews ha commentato con focus su tool, framework (20 commenti).

Risorse #

Link Originali #

Articolo segnalato e selezionato dal team Human Technology eXcellence elaborato tramite intelligenza artificiale (in questo caso con LLM HTX-EU-Mistral3.1Small) il 2025-09-06 10:51 Fonte originale: https://news.ycombinator.com/item?id=44110584

Articoli Correlati #

- Snorting the AGI with Claude Code - Code Review, AI, Best Practices

- My trick for getting consistent classification from LLMs - Foundation Model, Go, LLM

- Opencode: AI coding agent, built for the terminal - AI Agent, AI