Tipo: GitHub Repository

Link originale: https://github.com/rasbt/LLMs-from-scratch

Data pubblicazione: 2025-09-04

Sintesi #

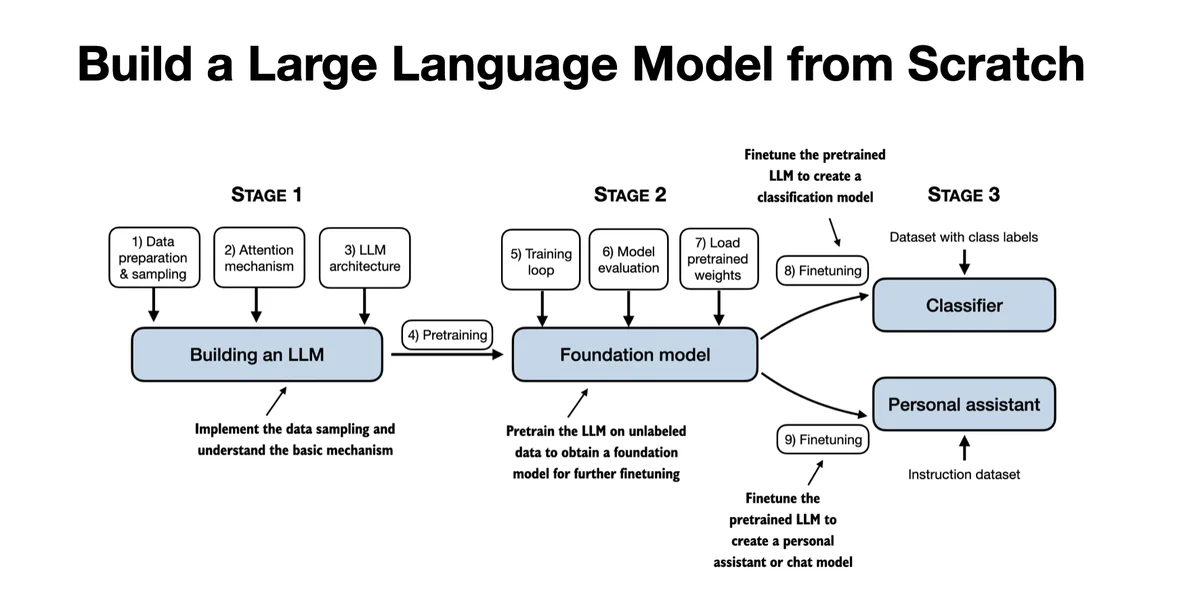

WHAT - Questo è un repository GitHub che contiene il codice per sviluppare, pre-addestrare e fine-tunare un modello di linguaggio di grandi dimensioni (LLM) simile a ChatGPT, scritto in PyTorch. È il codice ufficiale per il libro “Build a Large Language Model (From Scratch)” di Manning.

WHY - È rilevante per il business AI perché fornisce una guida dettagliata e pratica per costruire e comprendere LLMs, permettendo di replicare e adattare tecniche avanzate di elaborazione del linguaggio naturale. Questo può accelerare lo sviluppo di modelli personalizzati e migliorare la competenza interna.

WHO - Gli attori principali sono Sebastian Raschka (autore del libro e del repository), Manning Publications (editore del libro), e la community di sviluppatori su GitHub che contribuisce e utilizza il repository.

WHERE - Si posiziona nel mercato dell’educazione e dello sviluppo di LLMs, offrendo risorse pratiche per chi vuole costruire modelli di linguaggio avanzati. È parte dell’ecosistema PyTorch e si rivolge a sviluppatori e ricercatori interessati a LLMs.

WHEN - Il repository è attivo e in continua evoluzione, con aggiornamenti regolari. È un progetto consolidato ma in crescita, riflettendo i trend attuali nello sviluppo di LLMs.

BUSINESS IMPACT:

- Opportunità: Accelerare lo sviluppo di modelli di linguaggio personalizzati, migliorare la competenza interna, e ridurre i costi di formazione.

- Rischi: Dipendenza da un singolo repository per la formazione, rischio di obsolescenza se non aggiornato regolarmente.

- Integrazione: Può essere integrato nello stack esistente di sviluppo AI, utilizzando PyTorch e altre tecnologie menzionate nel repository.

TECHNICAL SUMMARY:

- Core technology stack: PyTorch, Python, Jupyter Notebooks, e vari framework di elaborazione del linguaggio naturale.

- Scalabilità: Il repository è progettato per educazione e prototipazione, non per scalabilità industriale. Tuttavia, le tecniche possono essere scalate utilizzando infrastrutture cloud.

- Differenziatori tecnici: Implementazione dettagliata di meccanismi di attenzione, pre-addestramento e fine-tuning, con esempi pratici e soluzioni agli esercizi.

Casi d’uso #

- Private AI Stack: Integrazione in pipeline proprietarie

- Client Solutions: Implementazione per progetti clienti

- Development Acceleration: Riduzione time-to-market progetti

- Strategic Intelligence: Input per roadmap tecnologica

- Competitive Analysis: Monitoring ecosystem AI

Feedback da terzi #

Community feedback: Gli utenti apprezzano le risorse condivise per costruire e comprendere modelli di linguaggio, con un consenso generale sull’utilità delle guide e delle implementazioni. Le principali preoccupazioni riguardano la complessità e l’accessibilità delle tecniche di fine-tuning, con richieste di ulteriori tutorial specifici per compiti di elaborazione del linguaggio naturale.

Risorse #

Link Originali #

- Build a Large Language Model (From Scratch) - Link originale

Articolo segnalato e selezionato dal team Human Technology eXcellence elaborato tramite intelligenza artificiale (in questo caso con LLM HTX-EU-Mistral3.1Small) il 2025-09-04 19:22 Fonte originale: https://github.com/rasbt/LLMs-from-scratch

Articoli Correlati #

- AI Engineering Hub - Open Source, AI, LLM

- nanochat - Python, Open Source

- Introducing Qwen3-Max-Preview (Instruct) - AI, Foundation Model