Tipo: GitHub Repository

Link originale: https://github.com/Olow304/memvid

Data pubblicazione: 2025-09-04

Sintesi #

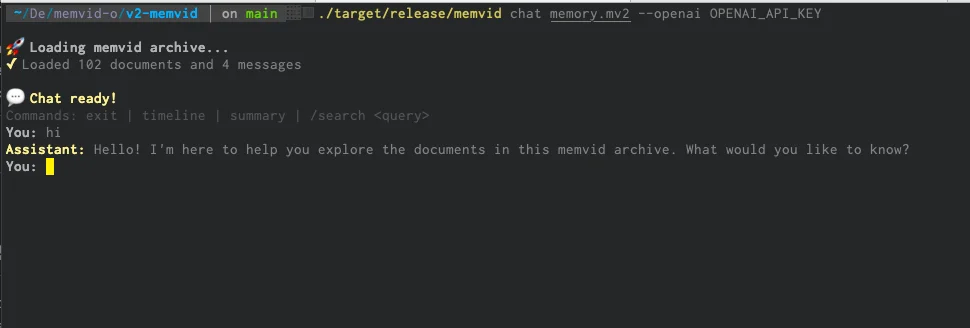

WHAT - Memvid è una libreria Python per la gestione della memoria AI basata su video. Comprime milioni di frammenti di testo in file MP4, permettendo ricerche semantiche veloci senza necessità di database.

WHY - Memvid è rilevante per il business AI perché offre una soluzione di memoria portabile, efficiente e senza infrastruttura, ideale per applicazioni offline-first e con requisiti di portabilità elevati.

WHO - Memvid è sviluppato da Olow304, con una community attiva su GitHub. Competitor indiretti includono soluzioni di gestione della memoria basate su database tradizionali e vector databases.

WHERE - Memvid si posiziona nel mercato delle soluzioni di memoria AI, offrendo un’alternativa innovativa basata su video compressione. È particolarmente rilevante per applicazioni che richiedono portabilità e efficienza senza infrastruttura.

WHEN - Memvid è attualmente in fase sperimentale (v1), con una roadmap chiara per la versione v2 che introduce nuove funzionalità come il Living-Memory Engine e il Time-Travel Debugging.

BUSINESS IMPACT:

- Opportunità: Integrazione con sistemi di Retrieval-Augmented Generation (RAG) per migliorare la gestione della memoria in applicazioni AI. Possibilità di offrire soluzioni di memoria portabili e offline-first ai clienti.

- Rischi: Competizione con soluzioni di memoria basate su database tradizionali e vector databases. Dipendenza dalla maturità e stabilità della versione v2.

- Integrazione: Memvid può essere integrato con lo stack esistente per migliorare la gestione della memoria in applicazioni AI, sfruttando la sua efficienza e portabilità.

TECHNICAL SUMMARY:

- Core technology stack: Python, video codecs (AV1, H.266), QR encoding, semantic search.

- Scalabilità: Memvid può gestire milioni di frammenti di testo, ma la scalabilità dipende dall’efficienza dei codec video utilizzati.

- Limitazioni architetturali: La compressione basata su video potrebbe non essere ottimale per tutti i tipi di dati testuali, come evidenziato dalla community.

- Differenziatori tecnici: Utilizzo di codec video per la compressione dei dati testuali, portabilità e efficienza senza infrastruttura, ricerca semantica veloce.

Casi d’uso #

- Private AI Stack: Integrazione in pipeline proprietarie

- Client Solutions: Implementazione per progetti clienti

- Development Acceleration: Riduzione time-to-market progetti

- Strategic Intelligence: Input per roadmap tecnologica

- Competitive Analysis: Monitoring ecosystem AI

Feedback da terzi #

Community feedback: La community ha espresso preoccupazioni sull’efficienza del metodo di compressione proposto, sottolineando che i codec video non sono ottimali per dati testuali come i codici QR. Alcuni utenti hanno anche discusso le prestazioni e la latenza di soluzioni alternative.

Risorse #

Link Originali #

- Memvid - Link originale

Articolo segnalato e selezionato dal team Human Technology eXcellence elaborato tramite intelligenza artificiale (in questo caso con LLM HTX-EU-Mistral3.1Small) il 2025-09-06 10:47 Fonte originale: https://github.com/Olow304/memvid

Articoli Correlati #

- MemoRAG: Moving Towards Next-Gen RAG Via Memory-Inspired Knowledge Discovery - Open Source, Python

- GitHub - GibsonAI/Memori: Open-Source Memory Engine for LLMs, AI Agents & Multi-Agent Systems - AI, Open Source, Python

- RAGFlow - Open Source, Typescript, AI Agent