Tipo: GitHub Repository

Link originale: https://github.com/FareedKhan-dev/qwen3-MoE-from-scratch

Data pubblicazione: 2025-09-20

Sintesi #

WHAT - Questo è un tutorial che guida alla costruzione di un modello Qwen 3 MoE (Mixture-of-Experts) da zero, utilizzando Jupyter Notebook. Il tutorial è basato su un articolo di Medium e include un repository GitHub con codice e risorse aggiuntive.

WHY - È rilevante per il business AI perché fornisce una guida pratica per implementare un modello avanzato di LLM (Large Language Model) che può essere utilizzato per migliorare le capacità di elaborazione del linguaggio naturale. Questo può portare a soluzioni più efficienti e specializzate per applicazioni AI.

WHO - Gli attori principali includono Fareed Khan, autore del tutorial, e Alibaba, che ha sviluppato il modello Qwen 3. La community di sviluppatori e ricercatori AI è il pubblico principale.

WHERE - Si posiziona nel mercato educativo AI, offrendo risorse per lo sviluppo di modelli avanzati di LLM. È parte dell’ecosistema di strumenti open-source per l’AI.

WHEN - Il tutorial è stato pubblicato nel 2025, indicando che si basa su tecnologie recenti e avanzate. La maturità del contenuto è legata alla diffusione e all’adozione del modello Qwen 3.

BUSINESS IMPACT:

- Opportunità: Implementare modelli MoE può migliorare l’efficienza e la specializzazione delle soluzioni AI, offrendo un vantaggio competitivo.

- Rischi: La dipendenza da tecnologie open-source può comportare rischi legati alla manutenzione e all’aggiornamento del codice.

- Integrazione: Il tutorial può essere utilizzato per formare il team di sviluppo interno, integrando le conoscenze acquisite nello stack tecnologico esistente.

TECHNICAL SUMMARY:

- Core technology stack: Jupyter Notebook, Python, PyTorch, Hugging Face Hub, sentencepiece, tiktoken, torch, matplotlib, tokenizers, safetensors.

- Scalabilità e limiti architetturali: Il modello descritto ha 0.8 miliardi di parametri, molto meno rispetto ai 235 miliardi del modello originale Qwen 3. Questo lo rende più gestibile ma anche meno potente.

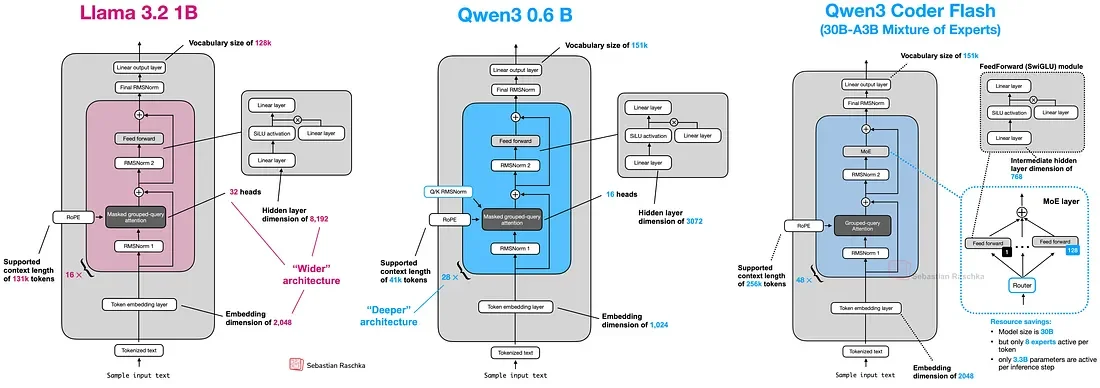

- Differenziatori tecnici chiave: Utilizzo di Mixture-of-Experts (MoE) per attivare solo una parte dei parametri per query, migliorando l’efficienza senza sacrificare le prestazioni. Implementazione di tecniche avanzate come Grouped-Query Attention (GQA) e RoPE (Rotary Position Embedding).

Casi d’uso #

- Private AI Stack: Integrazione in pipeline proprietarie

- Client Solutions: Implementazione per progetti clienti

- Development Acceleration: Riduzione time-to-market progetti

- Strategic Intelligence: Input per roadmap tecnologica

- Competitive Analysis: Monitoring ecosystem AI

Risorse #

Link Originali #

Articolo segnalato e selezionato dal team Human Technology eXcellence elaborato tramite intelligenza artificiale (in questo caso con LLM HTX-EU-Mistral3.1Small) il 2025-09-23 16:51 Fonte originale: https://github.com/FareedKhan-dev/qwen3-MoE-from-scratch

Articoli Correlati #

- AI Engineering Hub - Open Source, AI, LLM

- Introducing Qwen3-Max-Preview (Instruct) - AI, Foundation Model

- Kimi K2: Open Agentic Intelligence - AI Agent, Foundation Model